去年,麻省理工学院的研究人员宣布,他们受到小物种大脑的启发,建立了“液体”神经网络:一类灵活、强大的机器学习模型,可以在工作中学习并适应不断变化的条件,以确保现实世界的安全-关键任务,例如驾驶和飞行。这些“液体”神经网络的灵活性意味着增强我们互联世界的血统,为涉及时间序列数据的许多任务(例如大脑和心脏监测、天气预报和股票定价)提供更好的决策。

但随着神经元和突触数量的增加,这些模型的计算成本变得昂贵,并且需要笨重的计算机程序来解决其基础的复杂数学问题。所有这些数学,与许多物理现象类似,随着尺寸的增加而变得更难解决,这意味着需要计算大量的小步骤才能得出解决方案。

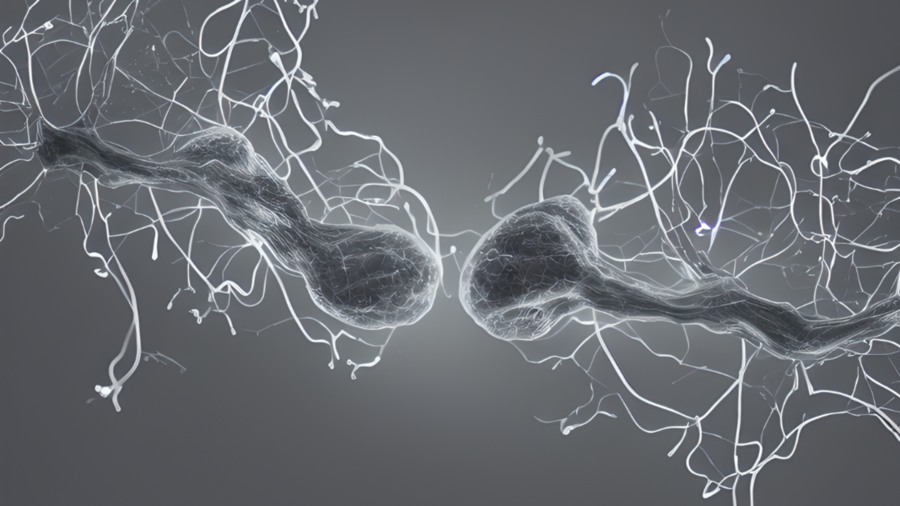

现在,同一科学家团队发现了一种缓解这一瓶颈的方法,通过求解两个神经元通过突触相互作用背后的微分方程来解锁一种新型的快速高效的人工智能算法。这些模式具有与液体神经网络相同的特征——灵活、因果、鲁棒和可解释——但速度要快几个数量级,并且可扩展。因此,这种类型的神经网络可以用于任何涉及随着时间的推移洞察数据的任务,因为它们即使在训练后也是紧凑且适应性强的——而许多传统模型是固定的。自 1907 年(神经元模型微分方程引入的那一年)以来,一直没有已知的解决方案。

这些模型被称为“封闭式连续时间”(CfC)神经网络,在许多任务上都优于最先进的模型,在通过运动传感器识别人类活动、对物理模型进行建模等方面具有显着更高的加速和性能。模拟步行机器人的动力学,以及基于事件的顺序图像处理。例如,在医疗预测任务中,新模型在对 8,000 名患者进行抽样时速度提高了 220 倍。

关于这项工作的新论文今天发表在《自然机器智能》上。

“我们称之为‘CfC’的新机器学习模型用封闭形式近似取代了定义神经元计算的微分方程,保留了液体网络的美丽特性,而不需要数值积分,”麻省理工学院主任 Daniela Rus 教授说计算机科学与人工智能实验室(CSAIL)的教授,也是这篇新论文的高级作者。“CfC 模型具有因果性、紧凑性、可解释性,且训练和预测效率高。它们为安全关键型应用开辟了值得信赖的机器学习之路。”

保持事物的流动性

微分方程使我们能够计算世界的状态或现象的演变,但不能随着时间的推移一直计算——只是一步一步地计算。为了对随时间变化的自然现象进行建模并了解以前和未来的行为,例如人类活动识别或机器人的路径,该团队研究了一系列数学技巧来找到答案:一个“封闭形式”的解决方案,可以对在单个计算步骤中对整个系统的完整描述。

通过他们的模型,人们可以在未来的任何时间和过去的任何时间计算这个方程。不仅如此,计算速度也快得多,因为您不需要一步步求解微分方程。

想象一个端到端的神经网络,它接收来自安装在汽车上的摄像头的驾驶输入。该网络经过训练可以生成输出,例如汽车的转向角。2020 年,该团队通过使用具有 19 个节点的液体神经网络解决了这个问题,因此 19 个神经元加上一个小型感知模块就可以驾驶汽车。微分方程描述了该系统的每个节点。使用封闭式解决方案,如果您在该网络内替换它,它将为您提供准确的行为,因为它很好地近似了系统的实际动态。因此,他们可以用更少数量的神经元来解决问题,这意味着速度更快、计算成本更低。

这些模型可以接收时间序列(及时发生的事件)的输入,可用于分类、控制汽车、移动人形机器人或预测金融和医疗事件。通过所有这些不同的模式,它还可以提高准确性、鲁棒性和性能,更重要的是,提高计算速度——有时这是一种权衡。

解决这个方程对于推进自然和人工智能系统的研究具有深远的影响。“当我们对神经元和突触通信有了封闭形式的描述时,我们就可以构建具有数十亿个细胞的大脑计算模型,由于神经科学模型的计算复杂性很高,这种能力在今天是不可能实现的。闭式方程可以促进这种宏观模拟,从而为我们理解智能开辟新的研究途径。”新论文的第一作者、麻省理工学院 CSAIL 研究成员 Ramin Hasani 说道。

便携式学习

此外,早期证据表明 Liquid CfC 模型可以在一种环境中通过视觉输入学习任务,并将所学到的技能转移到全新的环境中,而无需额外的培训。这称为分布外泛化,是人工智能研究最基本的开放挑战之一。

“基于微分方程的神经网络系统很难求解,也很难扩展到数百万和数十亿个参数。获得神经元如何相互作用的描述,不仅仅是阈值,而且解决细胞之间的物理动力学使我们能够建立更大规模的神经网络,”哈萨尼说。“这个框架可以帮助解决更复杂的机器学习任务——实现更好的表示学习——并且应该成为任何未来嵌入式智能系统的基本构建块。”

Aurora Flight Sciences 人工智能和机器学习小组负责人 Sildomar Monteiro 表示:“最近的神经网络架构,例如神经常微分方程和液体神经网络,具有由代表无限潜在状态的特定动力系统组成的隐藏层,而不是显式的层堆栈。”波音公司,未参与本文。“这些隐式定义的模型展现了最先进的性能,同时所需的参数比传统架构少得多。然而,由于训练和推理所需的计算成本很高,它们的实际采用受到限制。

Hasani 和麻省理工学院 CSAIL 博士后马蒂亚斯·莱赫纳 (Mathias Lechner) 与麻省理工学院 CSAIL 博士后亚历山大·阿米尼 (Alexander Amini) 一起在 Rus 的指导下撰写了这篇论文。Lucas Liebenwein SM ’18,博士 ’21;Aaron Ray,麻省理工学院电气工程和计算机科学博士生,CSAIL 附属机构;Max Tschaikowski,丹麦奥尔堡大学计算机科学副教授;以及维也纳大学数学教授 Gerald Teschl。

323AI导航网发布