新的 LiGO 技术可加速大型机器学习模型的训练,降低开发人工智能应用程序的资金和环境成本。

众所周知,OpenAI 的 ChatGPT 具有一些令人难以置信的功能 – 例如,聊天机器人可以写出类似于莎士比亚十四行诗的诗歌或调试计算机程序代码。ChatGPT 所基于的大规模机器学习模型使这些能力成为可能。研究人员发现,当这些类型的模型变得足够大时,就会出现非凡的能力。

但更大的模型也需要更多的时间和金钱来训练。训练过程涉及向模型显示数千亿个示例。收集如此多的数据本身就是一个复杂的过程。接下来是运行许多强大的计算机数天或数周来训练可能具有数十亿参数的模型的金钱和环境成本。

“据估计,ChatGPT 假设运行的训练模型规模可能需要数百万美元,仅用于一次训练运行。我们能否提高这些训练方法的效率,以便我们仍然可以用更少的时间和更少的钱获得好的模型?我们建议通过利用之前训练过的较小语言模型来实现这一目标。”麻省理工学院电气工程和计算机科学系助理教授、计算机科学和人工智能实验室 (CSAIL) 成员 Yoon Kim 说道。

Kim 和他的合作者并没有放弃模型的先前版本,而是将其用作新模型的构建块。使用机器学习,他们的方法学习从较小的模型“成长”为更大的模型,其方式是对较小模型已经获得的知识进行编码。这可以更快地训练更大的模型。

与从头开始训练新模型的方法相比,他们的技术节省了训练大型模型所需的约 50 % 的计算成本。此外,使用 MIT 方法训练的模型的性能与使用其他技术训练的模型一样好,甚至更好,这些技术也使用较小的模型来更快地训练较大的模型。

减少训练大型模型所需的时间可以帮助研究人员以更少的费用更快地取得进展,同时还可以减少训练过程中产生的碳排放。它还可以使较小的研究小组能够使用这些大型模型,从而有可能为许多新进展打开大门。

“当我们寻求使这些类型的技术民主化时,使训练更快、成本更低将变得更加重要,”有关该技术的论文的高级作者 Kim 说。

Kim 和他的研究生 Lucas Torroba Hennigen 与主要作者、德克萨斯大学奥斯汀分校的研究生 Peihao Wang 以及 MIT-IBM Watson AI 实验室和哥伦比亚大学的其他人共同撰写了这篇论文。该研究将在国际学习表征会议上公布。

越大越好

像 GPT-3 这样的大型语言模型是 ChatGPT 的核心,它是使用称为 Transformer 的神经网络架构构建的。神经网络大致以人脑为基础,由互连的节点或“神经元”层组成。每个神经元都包含参数,这些参数是神经元用于处理数据的训练过程中学习到的变量。

Transformer 架构是独一无二的,因为随着这些类型的神经网络模型变得越来越大,它们会取得更好的结果。

“这导致了各家公司试图在越来越大的数据集上训练越来越大的变压器的军备竞赛。与其他架构相比,变压器网络似乎在扩展方面变得更好。我们只是不太确定为什么会出现这种情况,”金说。

这些模型通常具有数亿或数十亿个可学习参数。从头开始训练所有这些参数的成本很高,因此研究人员寻求加速这一过程。

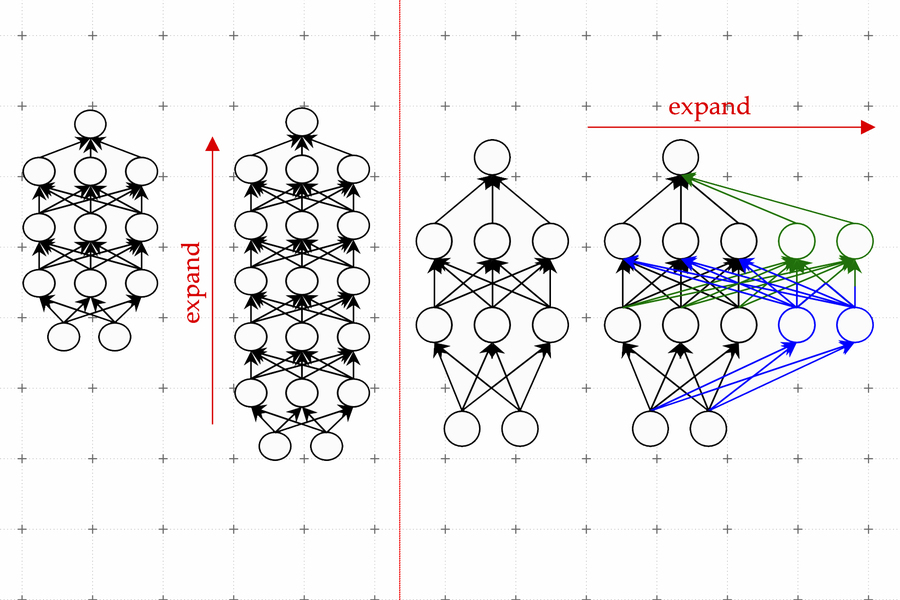

一种有效的技术称为模型增长。使用模型增长方法,研究人员可以通过复制神经元甚至先前版本网络的整个层,然后将它们堆叠在顶部来增加变压器的大小。他们可以通过向一层添加新神经元来使网络更宽,或者通过添加额外的神经元层来使其更深。

Kim 解释说,与以前的模型增长方法相比,与扩展变压器中的新神经元相关的参数不仅仅是较小网络参数的副本。相反,它们是较小模型参数的学习组合。

学习成长

Kim 和他的合作者使用机器学习来学习较小模型参数的线性映射。该线性映射是一种数学运算,它将一组输入值(在本例中为较小模型的参数)转换为一组输出值(在本例中为较大模型的参数)。

他们的方法被称为学习线性增长算子(LiGO),它学习以数据驱动的方式从较小网络的参数扩展较大网络的宽度和深度。

但较小的模型实际上可能相当大——也许它有一亿个参数——研究人员可能想要制作一个具有十亿个参数的模型。因此,LiGO 技术将线性地图分解为机器学习算法可以处理的更小的部分。

LiGO 还同时扩展了宽度和深度,这使得它比其他方法更有效。Kim 解释说,当用户输入较小的模型及其参数时,他们可以调整他们想要的较大模型的宽度和深度。

当他们将自己的技术与从头开始训练新模型的过程以及模型增长方法进行比较时,发现它比所有基线都快。他们的方法节省了训练视觉和语言模型所需的约 50% 的计算成本,同时通常还提高了性能。

研究人员还发现,即使他们无法访问更小的预训练模型,他们也可以使用 LiGO 来加速 Transformer 训练。

“令我惊讶的是,与随机初始化、从头开始训练基线相比,所有方法(包括我们的方法)的表现要好得多。” 金说。

未来,Kim 和他的合作者期待将 LiGO 应用到更大的模型中。

这项工作的部分资金来自 MIT-IBM Watson AI 实验室、亚马逊、IBM 研究人工智能硬件中心、伦斯勒理工学院计算创新中心和美国陆军研究办公室。

2023年6月29日消息:323ai导航网发布